いわゆる「ゆっくりボイス」のエンジン開発者に取材しました。

「ゆ っ く り し て い っ て ね ! ! !」

ニコニコ動画などで10年超にわたって使われているフレーズですから、ご存じの方は“脳内再生余裕でした”という感じでしょう。ゲーム実況などの分野では「ゆっくりボイス」と呼ばれる合成音声を使う手法が定着しており、耳にしただけで、丸っこくデフォルメされた東方Projectのキャラクターが頭に浮かぶ人もいるのではないでしょうか。

筆者は「魔理沙だぜ」の方が脳内再生しやすいです(AsciiArt*AsciiArtより)

しかし、意外と知られていないのは、この合成音声の“正体”です。

使用されているエンジン「AquesTalk」は本来、動画制作ではなく、組み込み用途向けに開発されたもの。また、有名声優などの声をベースにしているわけでもなく、エンジニアが自分の耳を頼りにチューニングし、手作業で作り上げたといいます。

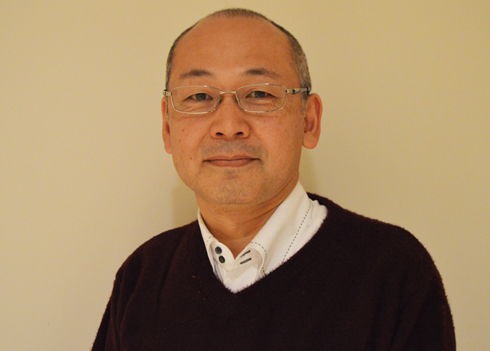

今や「日本におけるインターネット文化の1つ」といっても過言ではないゆっくりボイスは、なぜ誕生したのか。その不思議ないきさつについて、AquesTalk開発者・山崎信英氏を取材しました。

山崎氏

ゆっくりボイスを生んだ“起業エンジニアの生存戦略”

―― ゆっくりボイスに使われている「AquesTalk」は、どんな音声合成エンジンなのですか?

私はかれこれ30年以上、音声合成に関わっていて、2005年にアクエストという会社を立ち上げました。翌年、そこからリリースしたのがAquesTalkです。文章を音声に変換するテキスト音声合成が行えるのですが、軽量で組み込み用途での利用を想定しています。

この分野だとけっこう使われている方だと思いますよ。導入実績でいうと、数百万台を超えるんじゃないかなあ。例えば、電話機の「掛けてきた相手の名前を読みあげる機能」などに採用されています。インターネットに親しみのないおじいちゃん、おばあちゃんも意外と聞いてると思いますよ、ゆっくりボイス(笑)。

AquesTalk仕様。特徴は「軽量で実装しやすい合成音声エンジン」であること(アクエストWebサイトより)

―― どうやって開発されているのですか?

現在、音声合成エンジンの開発は「人間の声を収録 → 統計処理を施す → それを元にデータ作成」というやり方が多いのですが、AquesTalkのデータは私が全て手作業で作り込んでいます。

―― 他の製品と違って、人間の声をもとに作っているわけではない、と。

ええ、参考程度に使うことはありますけどね。Windows付属の「ペイント」で描いた波形を読み込ませたりして、最終的には全て自分の手で作ります。

1つの声質を作るのには、かかる期間は3カ月くらい。このやり方の方が、データ量が小さくできるんですよ。軽量さは、AquesTalkのコンセプトの1つですから。

―― ネット上でゲーム実況動画などに、使われるようになったのはなぜですか? 本来の用途とはかなり異なりますが……。

意図していたところもありますが、想定外なところもあります。ゆっくりボイスには確かにAquesTalkが使われていますが、正確に言うとあれは、同エンジンの声“ではない”んですよ。

―― 「意図していたところ」と「そうでないところ」があった。では、どういうことを意図していたのですか?

当社は「株式会社アクエスト」という形をとっていますが、実態としては個人事業に近くて、「どうすれば大手メーカーに立ち向かえるか」と考えていたんですね。