INDEX

チャットAI「ChatGPT」(有料の最新版)の、「人類の意図をくみ取る力」がすごすぎると話題です。「東京にあるでかいやつ」「じゃないほう」だけで、質問の意味を察した……!?

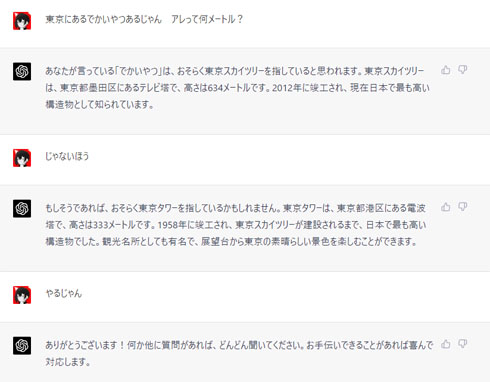

雑な指示の意図を推測して回答(画像提供:育良啓一郎さん)

その力が発揮されたのは、Twitterユーザーの育良啓一郎(@ikr_4185)さんが質問したときのこと。「東京にあるでかいやつあるじゃん アレって何メートル?」と入力したところ、「でかいやつ」が東京スカイツリーだと推測し、即座に634メートルと、その全高を答えました。

これに対し、追加で「じゃないほう」と入力したところ、AIはすぐに「もしそうであれば、おそらく東京タワーを指しているかもしれません」と回答。育良さんは「クソ指示でもここまで意図くむのヤバすぎ」と舌を巻きました。ちなみに、筆者が無料版で同じ質問を試したところ、ChatGPTは「でかいやつ」だけではうまく答えられず、こちらが「放送塔」と補足して初めて理解してくれました。

AIの有能ぶりは、「柔軟性が高い」「友だちみたい」「『じゃないほう』を質問と認識してくれるの偉すぎる」と話題に。育良さんはTwitter向けに140文字以内の自己紹介文を書かせたり、太宰治とプラトンが合体した「太宰オサトン」を創造させたり、ChatGPTでさまざまな試みをしています。

コメントランキング

「回転寿司」でコスパ最強だと思うチェーンは?【アンケート実施中】(投票結果) | グルメ ねとらぼ

「戦国武将」で最強だと思うのは誰?【アンケート実施中】 | ライフスタイル ねとらぼ

「最強」だと思う松田聖子のシングル曲は?【2026年版・人気投票実施中】(投票結果) | 音楽 ねとらぼリサーチ

「これだけは外せない!」サイゼリヤの定番メニューはどれ?【アンケート実施中】(投票結果) | グルメ ねとらぼ

声優「諏訪部順一」が演じたテレビアニメキャラクターであなたが好きなのは誰?【2026年版・人気投票実施中】(投票結果) | アニメ ねとらぼリサーチ